کلان داده یا داده های عظیم چیست؟

با ورود به عصر اطلاعات و ارتباطات و آغاز استفاده از داده ها و اطلاعات به عنوان سرمایه های اصلی در حرکت علمی، اقتصادی، اجتماعی و فرهنگی جوامع، سازمان ها و شرکت های مختلف و توسعه مشارکت افراد در جهان اینترنت و ارتباطات شبکه ای در دنیا، دغدغه ای بروز پیدا کرد که از جنس همین داده هایی بود که همه روز و با سرعت وحشتناک در دنیا و در عرصه های مختلفی که فناوری اطلاعات ورود پیدا کرده بود، تولید می شود و آن اینکه چگونه این حجم بزرگ و متنوع داده ها و اطلاعات را با توجه به ساختار هایی که در فضای فناوری اطلاعات وجود دارد، می توان مدیریت، کنترل و پردازش کرد و از آن در جهت بهبود ساختارها و سودآوری بیشتر بهره جست؟

از سال ۲۰۱۲ به بعد در هر روز هزار پتا بایت (۱۰۰۰ Pebibyte) داده تولید می شود که به دنبال خود مستلزم ذخیره سازی، تحلیل، جستجوها، تمیزکاری داده ها، اشتراک ها و … در داده هاست که باید در حوزه مختلف انجام شود.

این موضوع باعث شده است که پژوهشگران و دانشمندان به دنبال ایجاد ساختارها، متدلوژی ها، روش ها و رویکردهای جدیدی برای مدیریت، کنترل و پردازش این حجم از داده ها باشند که این تلاش ها در ذیل سایه «داده های بزرگ» مطرح شده است.

مباحثی که مورد بررسی قرار می گیرد:

کلان داده (دادههای بزرگ)

داده های بزرگ معمولا به مجمعه از داده ها اطلاق می شود که اندازه آنها فراتر از حدی است که با نرم افزارهای معمول بتوان آنها را در یک زمان معقول اخذ، دقیق سازی، مدیریت و پردازش کرد (Snijders, 2012). مفهوم «اندازه» در داده های بزرگ بطور مستمر در حال تغییر است و به مرور بزرگتر می شود.

داده های بزرگ مجموعه از تکنیک ها و تاکتیک هایی است که نیازمند شکل جدیدی از یکپارچگی هستند تا بتوانند ارزش های بزرگی را که در مجموعه های بزرگ، وسیع، پیچیده و متنوع داده پنهان شده اند، آشکار سازند.

تعاریف داده های بزرگ

در سال ۲۰۰۱ موسسه گارتنر(Gartner)، (گروه متا) سه بعد از چالش ها و فرصت های پیش رو در حوزه رشد داده ها را مطرح کرد که عبارت بودند از:

- افزایش حجم (Volume): افزایش در میزان داده

- سرعت و شتاب (Velocity): افزایش سرعت تولید داده های ورودی و خروجی

- تنوع (Variety): افزایش محدوده تنوع و منابع داده ها

که این ویژگی ها (۳Vs) بعد از آن به عنوان ویژگی های اصلی و معرف داده های بزرگ مطرح شدند.

در سال ۲۰۱۲ موسسه گارتنر تعریف جدیدی را ارایه کرد:

«داده های بزرگ، حجم بالا، سرعت و شتاب بالا و تنوع بالایی از دادایی های اطلاعاتی هستند که نیازمند شکل جدیدی از پزدازش هستند تا بتوانند تصمیم گیری را غنی¬تر سازند، بینش جدیدی را کشف کنند و نیز فرآیندها را بهینه نمایند.»

علاوه بر این مفهوم جدیدی به نام «صحت» (Veracity) نیز به ویژگی های داده های بزرگ افزوده شد تا بتواند ان را بهتر توصیف نماید.

تعریف دیگر نیز وجود دارد: «داده های بزرگ حجم بالایی از داده های غیر ساخت یافته هستند که با سیستم های مدیریت داده های استاندارد قابل مدیریت و بهره برداری نیستند.»

تفاوت داده های بزرگ و هوش تجاری

با توجه به آنچه که گفته شد، بین داده های بزرگ و هوش تجاری (Business Intelligence) نیز تفاوت هایی وجود دارد.

هوش تجاری از آمار توصیفی از داده های با چگالی بالا برای اندازه گیری و نیز تشخیص روندهای موجود استفاده می کند.

داده های بزرگ از آمار استقرایی و مفهومی برای ارایه قوانین (رگرسیون، روابط غیرخطی و …) در مجموعه بزرگی از داده ها که چگالی اطلاعاتی کمتری دارند، استفاده می کند تا روابط، وابستگی ها و پیش بینی هایی را از رفتارها و خروجی ها ارایه نماید.

با این توضیحات ویژگی ها و مشخصات ارایه شده برای داده های بزرگ را می توان به شرح ذیل برشمرد:

الف. حجم : مقدار و میزان داده تولید شده در حوزه داده های بزرگ بسیار مهم است. در واقع حجم داده تعیین می کند که آیا میزان خاصی از داده ها در چهارچوب داده های بزرگ قرار می گیرد یا نه چرا که نام «داده های بزرگ» خود مفهوم بزرگی را به دنبال دارد.

ب. تنوع : تنوع داده ها برای کسانی که با تحلیل داده ها سر و کار دارند بسیار مهم است، چرا که به آنها کمک می کند تا به طور موثرتری بتوانند داده ها را در جهت مزیت های خود به کار بگیرند.

ج. سرعت و شتاب : شتاب و سرعت در حوزه داده های کلان به سرعت تولید داده ها و نیز به چگونگی سرعت تولید و پردازش داده ها برای اهداف پیش روی توسعه و رشد اشاره دارد.

د. تغییرات پذیری : این ویژگی مشکل بزرگی را برای تحلیل گران داده ها ایجاد می کند چرا که با گذشت زمان تناقضاتی را در داده ها ایجاد می کند که مانع مدیریت و پردازش موثر آنها می شود.

هـ. صحت : کیفیت داده هایی که از حوزه های مختلف به دست آمده است می تواند بسیار مهم باشد. دقت تجزیه و تحلیل داده ها به صحت اطلاعات منابع داده ای وابسته است.

و. پیچیدگی : مدیریت داده ها می تواند به یک فرآیند پیچیده تبدیل شود، مخصوصا زمانی که حجم زیادی از داده ها از منابع متعدد آمده باشد. این داده ها باید با همدیگر متصل شوند و ارتباط درستی بین آنها ایجاد گردد تا بتواند درک درستی از اطلاعات به وجود آورد. از این وضعیت در داده های بزرگ به پیچیدگی یاد می شود.

تجزیه و تحلیل در داده های بزرگ

تجزیه و تحلیل در داده های بزرگ شامل شش حوزه می باشد که عبارتند از:

ارتباط: حسگرها و شبکه ها

ابر: محاسبات و داده¬ها برخط

سایبر: مدل و حافظه

محتوا و زمینه: معانی و ارتباطات

جوامع: اشتراک و همکاری

سفارشی سازی: شخصی سازی و ارزش

معماری داده های بزرگ

در سال ۲۰۰۰ شرکت سیزینت (Seisint) چهارچوب اشتراک فایل توزیع شده را مبتنی بر C++ برای ذخیره سازی و جستجو در داده ها توسعه داد که می توانست داده های ساختاریافته، نمیه ساخت یافته و غیرساخت یافته را در چندین سرور توزیع شده ذخیره و توزیع کند.

در سال ۲۰۰۴ شرکت لکسیزنکسیز (LexisNexis) شرکت سیزینت و در سال ۲۰۰۸ شرکت چویزپوینت (ChoicePoint) را به همراه پلترفرم های پردازش موازی قدرتمند آنها را خرید و با ترکیب آنها سیستم HPCC را ارایه کرد که در سال ۲۰۱۱ تحت گواهی آپاچی ۲ به صورت بازمتن ارایه گردید. در حال حاضر HPCC و نیز Quantcast File System تنها سکوهایی هستند که به صورت عمومی در دسترس می باشند که قابلیت تحلیل هزاران ترابایت از داده ها را دارا هستند.

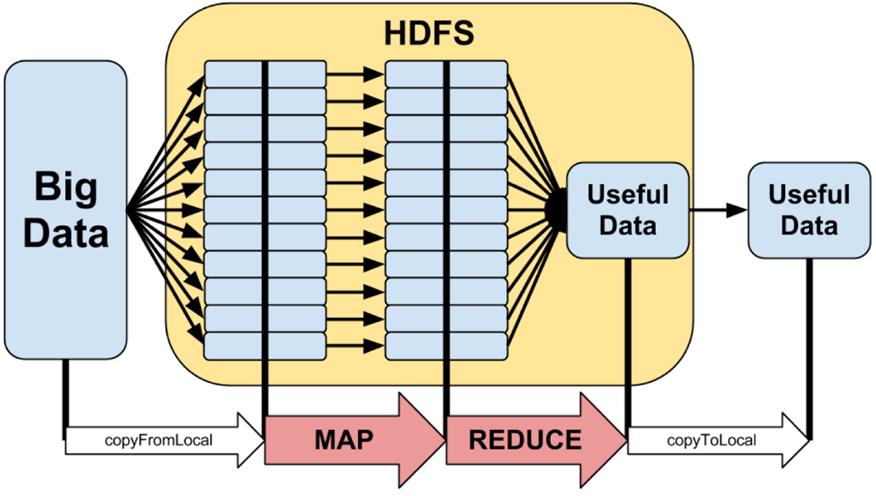

گوگل نیز در سال ۲۰۰۴ سندی را برای پردازشی با نام MapReduce منتشر کرد که از همان معماری استفاده می کرد. این چهارچوب نیز مدلی از پردازش موازی را ارایه می کند که می تواند پردازش ها و جستجوها را تجزیه کرده و در نودهای مختلف مورد پردازش قرار دهد (مرحله Map) و سپس آنها را جمع آوری کند (مرحله Reduce). این چهارچوب بسیار موفق بود و موجب شد تا دیگران نیز از همین الگوریتم استفاده کنند. بدین ترتیب پروژه ای بازمتن به نام Hadoop با به کارگیری این الگوریتم متولد شد. این چهار چوب از معماری Hadoop Distributed File System (HDFS)بهره می گیرد.

تکنولوژی های داده های بزرگ

داده های بزرگ به تکنولوژی های فوق العاده ای برای پردازش داده های عظیم در مجموعه های بزرگ نیازمند است تا بتواند در زمانی معقول پاسخگوی نیازها و اهداف تحلیل و پردازش داده ها باشد. در سال ۲۰۱۱ موسسه مککینزی (McKinsey) تکنولوژیهایی را برای داده های بزرگ پیشنهاد داد که جمع سپاری ، گداخت و یکپارچه سازی اطلاعات ، الگوریتم ژنتیک ، یادگیری ماشین ، پردازش زبان طبیعی ، پردازش سیگنال ، شبیه سازی ، تحلیل سری های زمانی و مصورسازی از جمله آنها بوده است.

دارپا (Defense Advanced Research Projects Agency (DARPA)) نیز در سال ۲۰۰۸ تحت عنوان شرکتی به نامAyasdi از تکنولوژی خود که به دنبال ساختارهای بنیادی در مجموعه های وسیع داده و تحلیل آنهاست، رونمایی کرده است.

کاربردهای داده های بزرگ

داده های بزرگ تقاضا برای متخصصان در این حوزه را به شدت بالا برده است و شرکت هایی چون Oracle، IBM، Microsoft، SAP و … بیش از ۱۵ میلیارد دلار برای توسعه نرم افزارهای مدیریت و تحلیل داده سرمایه گذاری کرده اند.

داده های بزرگ نحوه کار سازمان ها و افراد را تحت تاثیر قرار می دهد. داده های بزرگ فرهنگی را در سازمان ها ایجاد می کند که از طریق آن کسب و کارها و مدیران فناوری اطلاعات را به سمت استفاده از تمامی ارزش های پنهان در داده ها سوق می دهد. ادراک این ارزش ها به همه کارکنان سازمان ها این امکان را می دهد که با بینش وسیع تری تصمیم گیری کنند، نزدیکی بیشتری با مشتریان داشته باشند، فعالیت های خود را بهینه کنند، با تهدیدات مقابله کنند و در نهایت سرمایه های خود را بر روی منبع جدیدی از سود سرشار پنهان در داده ها متمرکز سازند. سازمان ها برای رسیدن به این مرحله نیازمند معماری جدید، ابزارهای نو و فعالیت ها و تلاش های مستمری هستند تا بتوانند از مزیت های چهارچوب های مبتنی بر داده های بزرگ بهره مند گردند.

بخش دولتی

در بخش دولتی استفاده از داده های بزرگ سبب کاهش هزینه ها، افزایش بهره وری و نیز ظهور و بروز نوآوری های جدید می شود. لیکن در بخش دولتی استفاده از چهارچوب های مبنی بر داده های بزرگ نیازمند همکاری بخش های مختلفی، از جمله وزارتخانه ها و نیز بخش های محلی و شرکت های دولتی است. در ادامه به بخشی از فعالیت های انجام شده در کشور های مختلف در حوزه داده های بزرگ اشاره می کنیم.

در ایالات متحده امریکا در سال ۲۰۱۲ دولت امریکا برای انجام پروژه ها و حل مسائل دولتی این کشور اعلانی را مبنی بر استفاده از طرح های تحقیقات و توسعه در حوزه داده های بزرگ اعلام کرد که مبتنی بر ۸۴ طرح بود که در شش گروه تقسیم بندی شده است.

در انگلستان یکی از بهترین مثال های استفاده از داده های بزرگ در بش خدمات عمومی اتفاق افتاده است و به عنوان مثال داده های هواشناسی و کلیه خدماتی که از آن ناشی می شود از طریق چهارچوب های داده های بزرگ مدیریت می شود.

بخش خصوصی

در بخش خصوصی مثال های زیادی از کاربردهای داده های بزرگ می توان بر شمرد. شرکت eBay از دو انباره داده ۷.۵ پتابایتی (۷.۵ PetaBytes) به همراه دو انباره ۴۰ پتابایت (۴۰ PetaBytes) در Hadoop برای تحقیقات و سیستم پیشنهاد به مشتری و فروش استفاده می کند.

شرکت آمازون روزانه میلیون ها عملیات را در داخل شرکت و نیز عملیات مربوط به همکاران خود را مدیریت می کند به طوری که از سال ۲۰۰۵ سه دیتابیس بزرگ جهان بر روی لینوکس را به خود اختصاص داده است.

مثال های دیگری نیز می توان از جمله شرکت والمارت (Walmart) که روزانه بیش از ۱ میلیون تراکنش مشتریان خود را مدیریت می کند.

رحیم خانی زاد، دکتری فناوری اطلاعات r.khanizad@dadekavan.ir